บิ๊กดาต้าคืออะไร? เหตุใดการวิเคราะห์ข้อมูลขนาดใหญ่จึงมีความสำคัญ

เผยแพร่แล้ว: 2019-11-02ข้อมูลมีบทบาทสำคัญในชีวิตของเรามานานหลายศตวรรษ ที่กล่าวว่าในแต่ละวัน เราสร้างข้อมูล 2.5 quintillion ไบต์ ซึ่งหมายความว่า 90% ของข้อมูลทั่วโลกถูกสร้างขึ้นในช่วงสองปีที่ผ่านมาเพียงอย่างเดียว และชุดข้อมูลขนาดมหึมาที่ใหญ่มากจนไม่สามารถวิเคราะห์โดยใช้วิธีการแบบเดิมๆ ได้ เรียกว่าบิ๊กดาต้า เพื่อตรวจสอบข้อมูลที่มีโครงสร้างและไม่มีโครงสร้างนี้ใช้เทคนิคการวิเคราะห์ Big Data

ในบทความนี้ เราจะพูดถึงว่าข้อมูลปริมาณมากคืออะไร Big Data Analytics คืออะไร และเหตุใดจึงสำคัญ

บิ๊กดาต้าคืออะไร?

- มันเป็นผลิตภัณฑ์?

- เป็นชุดเครื่องมือ?

- เป็นชุดข้อมูลที่ใช้โดยธุรกิจขนาดใหญ่เท่านั้นหรือไม่?

- ธุรกิจขนาดใหญ่จัดการกับพื้นที่เก็บข้อมูลขนาดใหญ่อย่างไร

- ขนาดของข้อมูลนี้คืออะไร?

- การวิเคราะห์ข้อมูลขนาดใหญ่คืออะไร?

- ความแตกต่างระหว่างข้อมูลขนาดใหญ่และ Hadoop คืออะไร?

คำถามเหล่านี้และคำถามอื่นๆ หลายข้ออยู่ในใจเมื่อเราค้นหาคำตอบว่าบิ๊กดาต้าคืออะไร? โอเค คำถามสุดท้ายอาจไม่ใช่สิ่งที่คุณถาม แต่คำถามอื่นๆ ก็เป็นไปได้

ดังนั้น ในที่นี้ เราจะมานิยามว่ามันคืออะไร จุดประสงค์หรือคุณค่าของมันคืออะไร และเหตุใดเราจึงใช้ข้อมูลจำนวนมาก

ธุรกิจในปัจจุบันต่างมองหาวิธีใหม่และดีกว่าในการรักษาความสามารถในการแข่งขัน ทำกำไร และเตรียมพร้อมสำหรับอนาคต และตามที่ผู้เชี่ยวชาญในอุตสาหกรรม การวิเคราะห์ Big Data เสนอวิธีการเรียนรู้แนวคิดใหม่ ดึงข้อมูลเชิงลึกใหม่ๆ และนำหน้าคู่แข่ง

บิ๊กดาต้า หมายถึงปริมาณมหาศาลของข้อมูลทั้งที่มีโครงสร้างและไม่มีโครงสร้างซึ่งมีอำนาจเหนือธุรกิจในแต่ละวัน แต่สิ่งสำคัญไม่ใช่ขนาดของข้อมูล สิ่งที่สำคัญคือวิธีการใช้และประมวลผลข้อมูล สามารถวิเคราะห์โดยใช้การวิเคราะห์ข้อมูลขนาดใหญ่เพื่อทำการตัดสินใจเชิงกลยุทธ์ที่ดีขึ้นสำหรับธุรกิจที่จะย้าย

ตามที่การ์ทเนอร์:

บิ๊กดาต้าเป็นสินทรัพย์สารสนเทศที่มีปริมาณมาก ความเร็วสูง และมีความหลากหลายสูง ซึ่งต้องการรูปแบบการประมวลผลข้อมูลที่เป็นนวัตกรรมและคุ้มต้นทุน เพื่อความเข้าใจที่ลึกซึ้งยิ่งขึ้นและการตัดสินใจ

ความสำคัญของบิ๊กดาต้า

วิธีที่ดีที่สุดในการทำความเข้าใจสิ่งใดสิ่งหนึ่งคือการรู้ประวัติของมัน

ข้อมูลมีมานานหลายปีแล้ว แต่แนวคิดนี้เริ่มมีแรงผลักดันในช่วงต้นทศวรรษ 2000 และตั้งแต่นั้นเป็นต้นมาธุรกิจต่างๆ ก็เริ่มรวบรวมข้อมูล เรียกใช้การวิเคราะห์ข้อมูลขนาดใหญ่เพื่อเปิดเผยรายละเอียดสำหรับใช้ในอนาคต จึงทำให้องค์กรสามารถทำงานได้อย่างรวดเร็วและคล่องตัว

นี่คือช่วงเวลาที่ Doug Laney กำหนดข้อมูลนี้เป็นสาม Vs (ปริมาตร ความเร็ว และความหลากหลาย):

ปริมาณ : คือจำนวนข้อมูลที่ย้ายจากกิกะไบต์เป็นเทราไบต์และอื่น ๆ

ความเร็ว: ความเร็วของการประมวลผลข้อมูลคือความเร็ว

ความ หลากหลาย: ข้อมูลมีหลายประเภทตั้งแต่แบบมีโครงสร้างไปจนถึงไม่มีโครงสร้าง ข้อมูลที่มีโครงสร้างมักจะเป็นตัวเลขในขณะที่ไม่มีโครงสร้าง เช่น ข้อความ เอกสาร อีเมล วิดีโอ เสียง ธุรกรรมทางการเงิน ฯลฯ

Vs ทั้งสามนี้ทำให้การทำความเข้าใจข้อมูลขนาดใหญ่เป็นเรื่องง่าย พวกเขาได้ชี้แจงอย่างชัดเจนว่าการจัดการข้อมูลปริมาณมากโดยใช้กรอบงานแบบเดิมนั้นไม่ใช่เรื่องง่าย นี่เป็นช่วงเวลาที่ Hadoop เกิดขึ้นและมีคำถามบางอย่างเช่น:

- Hadoop คืออะไร?

- Hadoop เป็นชื่ออื่นของข้อมูลขนาดใหญ่หรือไม่?

- Hadoop แตกต่างจากข้อมูลขนาดใหญ่หรือไม่?

ทั้งหมดนี้เกิดขึ้น

มาเริ่มตอบคำถามกันเลย

Big Data และ Hadoop

ลองเปรียบเทียบร้านอาหารเป็นตัวอย่างเพื่อทำความเข้าใจความสัมพันธ์ระหว่างข้อมูลขนาดใหญ่กับ Hadoop

ทอมเพิ่งเปิดร้านอาหารกับเชฟซึ่งเขาได้รับคำสั่ง 2 ครั้งต่อวัน เขาสามารถจัดการกับคำสั่งเหล่านี้ได้อย่างง่ายดาย เช่นเดียวกับ RDBMS แต่เมื่อถึงเวลา Tom คิดที่จะขยายธุรกิจและด้วยเหตุนี้เพื่อดึงดูดลูกค้าให้มากขึ้น เขาจึงเริ่มรับคำสั่งซื้อออนไลน์ เนื่องจากการเปลี่ยนแปลงนี้ อัตราที่เขาได้รับคำสั่งซื้อจึงเพิ่มขึ้น และตอนนี้แทนที่จะเป็น 2 เขาเริ่มได้รับคำสั่ง 10 รายการต่อชั่วโมง สิ่งเดียวกันนี้เกิดขึ้นกับข้อมูล ด้วยการแนะนำแหล่งต่างๆ เช่น สมาร์ทโฟน โซเชียลมีเดีย ฯลฯ การเติบโตของข้อมูลจึงกลายเป็นเรื่องใหญ่ แต่เนื่องจากการเปลี่ยนแปลงอย่างกะทันหันในการจัดการคำสั่งซื้อ/ข้อมูลจำนวนมากจึงไม่ใช่เรื่องง่าย ดังนั้นความต้องการกลยุทธ์ประเภทอื่นเพื่อจัดการกับปัญหานี้จึงเกิดขึ้น

เมื่อตระหนักถึงสถานการณ์นี้ ทอมเริ่มคิดหาทางแก้ไข ในทำนองเดียวกันกับความก้าวหน้าของข้อมูลเทคโนโลยีเริ่มสร้างในอัตราที่น่าตกใจ เพื่อรับมืออัตราสั่งมหาศาล ทอมจ้างเชฟเพิ่มอีก 4 คน ทุกอย่างเป็นไปด้วยดี แต่เนื่องจากชั้นวางอาหารที่ใช้โดยเชฟ 4 คนเหมือนกัน มันจึงกลายเป็นปัญหาคอขวด ดังนั้นวิธีแก้ปัญหาจึงไม่ค่อยมีประสิทธิภาพ

ในทำนองเดียวกัน เพื่อจัดการกับปัญหาข้อมูล ชุดข้อมูลขนาดใหญ่ มีการติดตั้งหน่วยประมวลผลหลายตัว แต่ไม่ได้ผล เนื่องจากหน่วยจัดเก็บข้อมูลแบบรวมศูนย์กลายเป็นคอขวด ซึ่งหมายความว่าหากหน่วยส่วนกลางหยุดทำงาน ระบบทั้งหมดจะถูกบุกรุก ดังนั้นจึงจำเป็นต้องมองหาโซลูชันที่ดีกว่าสำหรับทั้งข้อมูลและร้านอาหาร

ทอมมาพร้อมกับวิธีแก้ปัญหาที่มีประสิทธิภาพ เขาแบ่งพ่อครัวออกเป็นสองลำดับชั้น ได้แก่ หัวหน้าและหัวหน้าพ่อครัว และมอบหมายชั้นวางอาหารให้กับเชฟรุ่นน้องแต่ละคน พูดเช่นจานเป็นซอสพาสต้า ตามแผนของทอม เชฟรุ่นน้องคนหนึ่งจะเตรียมพาสต้า และเชฟรุ่นน้องอีกคนจะเตรียมซอส ไปข้างหน้าพวกเขาจะมอบทั้งพาสต้าและซอสให้กับหัวหน้าพ่อครัวซึ่งหัวหน้าพ่อครัวจะเตรียมซอสพาสต้าหลังจากผสมส่วนผสมทั้งสองเข้าด้วยกันแล้วจะมีการส่งมอบคำสั่งสุดท้าย โซลูชันนี้ทำงานได้อย่างสมบูรณ์แบบสำหรับร้านอาหารของ Tom และสำหรับ Big Data วิธีนี้ทำได้โดย Hadoop

Hadoop เป็นเฟรมเวิร์กซอฟต์แวร์โอเพนซอร์ซที่ใช้ในการจัดเก็บและประมวลผลข้อมูลในลักษณะแบบกระจายบนคลัสเตอร์ฮาร์ดแวร์สินค้าโภคภัณฑ์ขนาดใหญ่ Hadoop จัดเก็บข้อมูลในรูปแบบกระจายพร้อมการจำลองแบบ เพื่อให้ทนต่อข้อผิดพลาดและให้ผลลัพธ์สุดท้ายโดยไม่มีปัญหาคอขวด ตอนนี้ คุณต้องมีความคิดแล้วว่า Hadoop แก้ปัญหาของ Big Data ie . ได้อย่างไร

- การจัดเก็บข้อมูลจำนวนมาก

- การจัดเก็บข้อมูลในรูปแบบต่างๆ: ไม่มีโครงสร้าง กึ่งโครงสร้าง และจัดโครงสร้าง

- ความเร็วในการประมวลผลข้อมูล

นี่หมายความว่าทั้ง Big Data และ Hadoop เหมือนกันหรือไม่

เราไม่สามารถพูดอย่างนั้นได้เนื่องจากมีความแตกต่างระหว่างทั้งสอง

ความแตกต่างระหว่าง Big Data และ Hadoop คืออะไร?

- ข้อมูลขนาดใหญ่ไม่มีอะไรมากไปกว่าแนวคิดที่แสดงถึงข้อมูลจำนวนมากในขณะที่ Apache Hadoop ใช้เพื่อจัดการข้อมูลจำนวนมาก

- มันซับซ้อนด้วยความหมายมากมายในขณะที่ Apache Hadoop เป็นโปรแกรมที่บรรลุเป้าหมายและวัตถุประสงค์

- ข้อมูลปริมาณมากนี้เป็นชุดของระเบียนต่างๆ โดยมีหลายรูปแบบในขณะที่ Apache Hadoop จัดการกับข้อมูลรูปแบบต่างๆ

- Hadoop เป็นเครื่องประมวลผลและบิ๊กดาต้าเป็นวัตถุดิบ

ตอนนี้เรารู้แล้วว่าข้อมูลนี้คืออะไร Hadoop และข้อมูลขนาดใหญ่ทำงานอย่างไร ถึงเวลาที่จะรู้ว่าบริษัทต่างๆ ได้รับประโยชน์จากข้อมูลนี้อย่างไร

บริษัทต่างๆ ได้รับประโยชน์จาก Big Data อย่างไร?

ตัวอย่างเล็กๆ น้อยๆ ที่อธิบายว่าข้อมูลขนาดใหญ่นี้ช่วยให้บริษัทต่างๆ ได้เปรียบมากขึ้นได้อย่างไร:

โคคาโคล่าและบิ๊กดาต้า

Coca-Cola เป็นบริษัทที่ไม่ต้องการการแนะนำ เป็นเวลาหลายศตวรรษแล้วที่บริษัทนี้เป็นผู้นำด้านสินค้าอุปโภคบริโภค ผลิตภัณฑ์ทั้งหมดมีการกระจายไปทั่วโลก สิ่งหนึ่งที่ทำให้ Coca Cola ชนะคือข้อมูล แต่อย่างไร

โคคาโคล่าและบิ๊กดาต้า :

การใช้ข้อมูลที่รวบรวมและวิเคราะห์ผ่านการวิเคราะห์ข้อมูลขนาดใหญ่ Coca Cola สามารถตัดสินใจได้จากปัจจัยต่อไปนี้:

- การเลือกส่วนผสมที่เหมาะสมในการผลิตผลิตภัณฑ์น้ำผลไม้

- จำหน่ายสินค้าในร้านอาหาร ขายปลีก ฯลฯ

- แคมเปญโซเชียลมีเดียเพื่อทำความเข้าใจพฤติกรรมผู้ซื้อโปรแกรมความภักดี

- การสร้างศูนย์บริการดิจิทัลเพื่อการจัดซื้อจัดจ้างและกระบวนการ HR

Netflix และบิ๊กดาต้า

เพื่อนำหน้าบริการสตรีมมิ่งวิดีโออื่นๆ Netflix จะวิเคราะห์แนวโน้มอย่างต่อเนื่องและทำให้แน่ใจว่าผู้คนได้รับสิ่งที่พวกเขามองหาใน Netflix พวกเขาค้นหาข้อมูลใน:

- รายการที่มีคนดูมากที่สุด

- เทรนด์ โชว์ลูกค้ากินรอ

- ภาพโปรโมต คลิก เวลาที่ใช้ดู

- อุปกรณ์ที่ลูกค้าใช้ดูรายการ

- สิ่งที่ผู้ดูชอบดูอย่างเมาสุรา ดูเป็นบางส่วน ย้อนหลัง หรือดูซีรีส์ทั้งเรื่อง

สำหรับบริษัทสตรีมมิ่งวิดีโอและความบันเทิงหลายแห่ง การวิเคราะห์ข้อมูลขนาดใหญ่เป็นกุญแจสำคัญในการรักษาสมาชิก รักษารายได้ และทำความเข้าใจประเภทของเนื้อหาที่ผู้ดูชอบตามสถานที่ตั้งทางภูมิศาสตร์ ข้อมูลจำนวนมากนี้ไม่เพียงแต่ให้ความสามารถนี้แก่ Netflix เท่านั้น แต่ยังช่วยให้บริการสตรีมวิดีโออื่น ๆ เข้าใจว่าผู้ดูต้องการอะไรและวิธีที่ Netflix และคนอื่นๆ สามารถนำเสนอได้

ควบคู่ไปกับบริษัทต่างๆ ที่จัดเก็บข้อมูลต่อไปนี้ซึ่งช่วยให้การวิเคราะห์ข้อมูลขนาดใหญ่ให้ผลลัพธ์ที่ถูกต้องแม่นยำ เช่น:

- ทวีตที่บันทึกไว้บนเซิร์ฟเวอร์ของ Twitter

- ข้อมูลที่จัดเก็บจากการติดตามการขี่รถโดย Google

- ผลการเลือกตั้งท้องถิ่นและระดับชาติ

- การรักษาที่ใช้และชื่อโรงพยาบาล

- ประเภทของบัตรเครดิตที่ใช้และการซื้อที่ต่างๆ

- จะเกิดอะไรขึ้นเมื่อคนดูบน Netflix, Amazon Prime, IPTV ฯลฯ และนานแค่ไหน

อืม นี่คือวิธีที่บริษัทต่างๆ รู้เกี่ยวกับพฤติกรรมของเรา และพวกเขาออกแบบบริการให้เรา

การวิเคราะห์ข้อมูลขนาดใหญ่คืออะไร?

กระบวนการศึกษาและตรวจสอบชุดข้อมูลขนาดใหญ่เพื่อทำความเข้าใจรูปแบบและรับข้อมูลเชิงลึกเรียกว่าการวิเคราะห์ข้อมูลขนาดใหญ่ มันเกี่ยวข้องกับกระบวนการอัลกอริธึมและคณิตศาสตร์เพื่อให้ได้มาซึ่งความสัมพันธ์ที่มีความหมาย จุดเน้นของการวิเคราะห์ข้อมูลคือการได้ข้อสรุปตามสิ่งที่นักวิจัยรู้

ความสำคัญของการวิเคราะห์ข้อมูลขนาดใหญ่

ตามหลักการแล้วบิ๊กดาต้าจะจัดการกับการคาดการณ์/การคาดการณ์ของข้อมูลขนาดใหญ่ที่รวบรวมจากแหล่งต่างๆ ซึ่งช่วยให้ธุรกิจตัดสินใจได้ดีขึ้น บางสาขาที่ใช้ข้อมูล ได้แก่ แมชชีนเลิร์นนิง ปัญญาประดิษฐ์ หุ่นยนต์ การดูแลสุขภาพ ความเป็นจริงเสมือน และส่วนอื่นๆ ดังนั้นเราจึงต้องรักษาข้อมูลให้ไม่เกะกะและเป็นระเบียบ

สิ่งนี้ทำให้องค์กรมีโอกาสเปลี่ยนแปลงและเติบโต และนี่คือเหตุผลที่การวิเคราะห์ข้อมูลขนาดใหญ่กำลังเป็นที่นิยมและมีความสำคัญสูงสุด ตามลักษณะของมัน เราสามารถแบ่งมันออกเป็น 4 ส่วนที่แตกต่างกัน:

นอกจากนี้ ข้อมูลขนาดใหญ่ยังมีบทบาทสำคัญในฟิลด์ต่อไปนี้:

- การระบุโอกาสใหม่

- การควบคุมข้อมูลในองค์กร

- รับผลกำไรที่สูงขึ้นและการดำเนินงานที่มีประสิทธิภาพ

- การตลาดที่มีประสิทธิภาพ

- บริการลูกค้าที่ดีขึ้น

- ความได้เปรียบในการแข่งขันเหนือคู่แข่ง

ตอนนี้เรารู้แล้วว่าข้อมูลทุกสาขามีบทบาทสำคัญอย่างไร ถึงเวลาทำความเข้าใจว่าบิ๊กดาต้าและ 4 ส่วนต่าง ๆ ของมันทำงานอย่างไร

การวิเคราะห์ข้อมูลขนาดใหญ่และวิทยาศาสตร์ข้อมูล

การวิเคราะห์ข้อมูลเกี่ยวข้องกับการใช้เทคนิคและเครื่องมือขั้นสูง เช่น การเรียนรู้ของเครื่อง การทำเหมืองข้อมูล สถิติ ข้อมูลที่ดึงมาจากแหล่งต่าง ๆ และในขนาดต่าง ๆ จะใช้ในการวิเคราะห์

ในทางกลับกัน Data Sciences เป็นคำศัพท์ในร่มที่มีวิธีการทางวิทยาศาสตร์ในการประมวลผลข้อมูล Data Sciences รวมหลายด้าน เช่น คณิตศาสตร์ การล้างข้อมูล ฯลฯ เพื่อเตรียมและจัดแนวข้อมูลขนาดใหญ่

เนื่องจากความซับซ้อนที่เกี่ยวข้อง วิทยาศาสตร์ข้อมูลจึงค่อนข้างท้าทาย แต่ด้วยการเติบโตของข้อมูลที่สร้างแนวคิดระดับโลกเกี่ยวกับข้อมูลจำนวนมากอย่างไม่เคยปรากฏมาก่อนก็พัฒนาขึ้นเช่นกัน ดังนั้นสาขาวิทยาศาสตร์ข้อมูลที่เกี่ยวข้องกับข้อมูลขนาดใหญ่จึงแยกออกไม่ได้ ข้อมูลครอบคลุมข้อมูลที่มีโครงสร้างและไม่มีโครงสร้างในขณะที่วิทยาศาสตร์ข้อมูลเป็นแนวทางที่มุ่งเน้นมากขึ้นซึ่งเกี่ยวข้องกับสาขาวิทยาศาสตร์เฉพาะ

ธุรกิจและการวิเคราะห์ข้อมูลขนาดใหญ่

เนื่องจากความต้องการใช้เครื่องมือในการวิเคราะห์ข้อมูลเพิ่มมากขึ้น เนื่องจากช่วยให้องค์กรค้นหาโอกาสใหม่ๆ และรับข้อมูลเชิงลึกใหม่ๆ เพื่อดำเนินธุรกิจอย่างมีประสิทธิภาพ

ยิ่งไปกว่านั้น โดยเน้นที่ลูกค้า บริษัทสามารถปรับปรุงการดำเนินงานและสร้างรายได้มากขึ้น เครื่องมืออย่าง Hadoop ช่วยในการลดต้นทุนการจัดเก็บ ด้วยเหตุนี้การเพิ่มประสิทธิภาพทางธุรกิจจึงนำไปสู่การประหยัดเงิน พลังงาน และการตัดสินใจที่รวดเร็วขึ้น

ประโยชน์แบบเรียลไทม์ของการวิเคราะห์ข้อมูลขนาดใหญ่

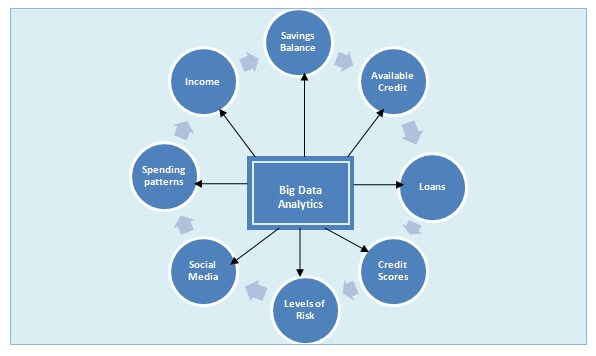

ข้อมูลในช่วงหลายปีที่ผ่านมามีการเติบโตอย่างมากเนื่องจากการใช้ข้อมูลเพิ่มขึ้นในอุตสาหกรรมต่างๆ ตั้งแต่:

- การธนาคาร

- ดูแลสุขภาพ

- พลังงาน

- เทคโนโลยี

- ผู้บริโภค

- การผลิต

โดยรวมแล้ว การวิเคราะห์ข้อมูลได้กลายเป็นส่วนสำคัญของบริษัทในปัจจุบัน

โอกาสในการทำงานและการวิเคราะห์ข้อมูลขนาดใหญ่

ข้อมูลมีอยู่เกือบทุกที่ ดังนั้นจึงมีความจำเป็นเร่งด่วนในการรวบรวมและรักษาข้อมูลใดๆ ก็ตามที่ถูกสร้างขึ้น นี่คือเหตุผลที่การวิเคราะห์ข้อมูลขนาดใหญ่อยู่ในขอบเขตของไอที และกลายเป็นส่วนสำคัญในการปรับปรุงธุรกิจและการตัดสินใจ ผู้เชี่ยวชาญที่มีทักษะในการวิเคราะห์ข้อมูลมีโอกาสมากมาย เนื่องจากพวกเขาเป็นคนที่สามารถเชื่อมช่องว่างระหว่างเทคนิคการวิเคราะห์ธุรกิจแบบดั้งเดิมและแบบใหม่ที่ช่วยให้ธุรกิจเติบโตได้

ประโยชน์ของการวิเคราะห์ข้อมูลขนาดใหญ่

- ลดต้นทุน

- การตัดสินใจที่ดีขึ้น

- สินค้าและบริการใหม่

- การตรวจจับการฉ้อโกง

- ข้อมูลเชิงลึกด้านการขายที่ดีขึ้น

- เข้าใจสภาวะตลาด

- ความถูกต้องของข้อมูล

- ปรับปรุงราคา

วิธีการทำงานของการวิเคราะห์ข้อมูลขนาดใหญ่และเทคโนโลยีที่สำคัญ

ไม่มีเทคโนโลยีใดที่สามารถครอบคลุมข้อมูลขนาดใหญ่ได้ แต่การวิเคราะห์ข้อมูลขนาดใหญ่ขั้นสูงสามารถนำไปใช้กับข้อมูล เพื่อให้ได้คุณค่าสูงสุดจากข้อมูล

นี่คือผู้เล่นที่ใหญ่ที่สุด:

การเรียนรู้ ของเครื่อง : การเรียนรู้ของเครื่อง ฝึกเครื่องให้เรียนรู้และวิเคราะห์ข้อมูลที่ใหญ่และซับซ้อนยิ่งขึ้นเพื่อส่งมอบผลลัพธ์ที่รวดเร็วและแม่นยำ การใช้ชุดย่อยแมชชีนเลิร์นนิงขององค์กร AI สามารถระบุโอกาสในการทำกำไร หลีกเลี่ยงความเสี่ยงที่ไม่รู้จัก

การจัดการข้อมูล: ด้วยข้อมูลที่ไหลเข้าและออกจากองค์กรอย่างต่อเนื่อง เราจำเป็นต้องรู้ว่าข้อมูลนั้นมีคุณภาพสูงหรือไม่และสามารถวิเคราะห์ได้อย่างน่าเชื่อถือ เมื่อข้อมูลมีความน่าเชื่อถือ โปรแกรมจัดการข้อมูลหลักจะใช้เพื่อให้องค์กรมีข้อมูลตรงกันและวิเคราะห์ข้อมูล

การทำเหมือง ข้อมูล : เทคโนโลยีการทำเหมืองข้อมูลช่วยวิเคราะห์รูปแบบข้อมูลที่ซ่อนอยู่ เพื่อให้สามารถนำมาใช้ในการวิเคราะห์เพิ่มเติมเพื่อหาคำตอบสำหรับคำถามทางธุรกิจที่ซับซ้อน การใช้ธุรกิจอัลกอริธึมการทำเหมืองข้อมูลสามารถตัดสินใจได้ดีขึ้น และสามารถระบุพื้นที่ที่มีปัญหาเพื่อเพิ่มรายได้ด้วยการลดต้นทุน การขุดข้อมูลเรียกอีกอย่างว่าการค้นพบข้อมูลและการค้นพบความรู้

Hadoop: Hadoop เป็นซอฟต์แวร์โอเพ่นซอร์สที่ช่วยจัดการการประมวลผลข้อมูลและการจัดเก็บแอปพลิเคชันข้อมูลในลักษณะที่เป็นระเบียบบนเซิร์ฟเวอร์คอมพิวเตอร์ Hadoop ได้กลายเป็นเทคโนโลยีหลักที่สนับสนุนความคิดริเริ่มในการวิเคราะห์บิ๊กดาต้าขั้นสูง รวมถึงการเรียนรู้ของเครื่อง การทำเหมืองข้อมูล เป็นต้น ระบบ Hadoop สามารถจัดการกับข้อมูลที่มีโครงสร้างและไม่มีโครงสร้างในรูปแบบต่างๆ ได้ ทำให้มีขอบพิเศษในการรวบรวม ประมวลผล และวิเคราะห์ข้อมูลได้อย่างง่ายดาย

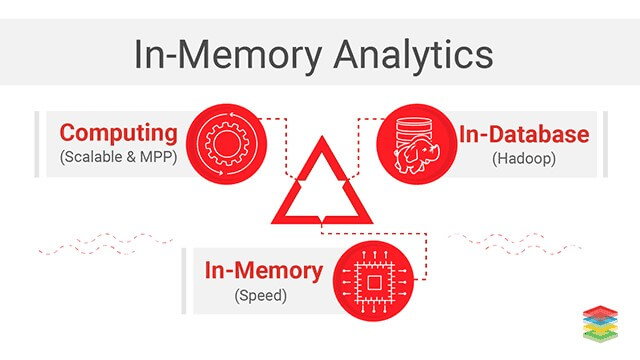

การวิเคราะห์ในหน่วยความจำ: วิธีการทางธุรกิจอัจฉริยะ (BI) นี้ใช้เพื่อแก้ปัญหาทางธุรกิจที่ซับซ้อน ด้วยการวิเคราะห์ข้อมูลจากเวลาตอบสนองการสืบค้นหน่วยความจำระบบของคอมพิวเตอร์ RAM สามารถสั้นลงและตัดสินใจทางธุรกิจได้เร็วขึ้น เทคโนโลยีนี้ขจัดแม้กระทั่งค่าใช้จ่ายในการจัดเก็บตารางรวมข้อมูลหรือการจัดทำดัชนีข้อมูล ส่งผลให้เวลาตอบสนองเร็วขึ้น ไม่เพียงแต่การวิเคราะห์ในหน่วยความจำนี้เท่านั้นยังช่วยให้องค์กรสามารถเรียกใช้การวิเคราะห์ข้อมูลขนาดใหญ่แบบวนซ้ำและโต้ตอบได้

การวิเคราะห์เชิงคาดการณ์ : การวิเคราะห์เชิง คาดการณ์คือวิธีการดึงข้อมูลจากข้อมูลที่มีอยู่เพื่อกำหนดและคาดการณ์ผลลัพธ์และแนวโน้มในอนาคต เทคนิคต่างๆ เช่น การทำเหมืองข้อมูล การสร้างแบบจำลอง การเรียนรู้ด้วยเครื่อง AI ใช้ในการวิเคราะห์ข้อมูลปัจจุบันเพื่อคาดการณ์ในอนาคต การวิเคราะห์เชิงคาดการณ์ช่วยให้องค์กรสามารถดำเนินการเชิงรุก คาดการณ์อนาคต คาดการณ์ผลลัพธ์ ฯลฯ ยิ่งไปกว่านั้น ยังดำเนินการต่อไปและแนะนำการดำเนินการเพื่อได้รับประโยชน์จากการคาดคะเน และยังให้การตัดสินใจเพื่อประโยชน์ในการคาดคะเนและความหมาย

การขุดข้อความ : การขุดข้อความเรียกอีกอย่างว่าการทำเหมืองข้อมูลข้อความเป็นกระบวนการในการรับข้อมูลคุณภาพสูงจากข้อมูลข้อความที่ไม่มีโครงสร้าง ด้วยเทคโนโลยีการขุดข้อความ คุณจะค้นพบข้อมูลเชิงลึกที่คุณไม่เคยสังเกตมาก่อน การทำเหมืองข้อความใช้การเรียนรู้ของเครื่องและเป็นประโยชน์มากขึ้นสำหรับนักวิทยาศาสตร์ข้อมูลและผู้ใช้รายอื่นในการพัฒนาแพลตฟอร์มข้อมูลขนาดใหญ่และช่วยวิเคราะห์ข้อมูลเพื่อค้นหาหัวข้อใหม่

ความท้าทายในการวิเคราะห์ข้อมูลขนาดใหญ่และวิธีที่สามารถแก้ไขได้

ข้อมูลจำนวนมหาศาลถูกสร้างขึ้นทุกนาที จึงเป็นงานที่ท้าทายในการจัดเก็บ จัดการ ใช้งานและวิเคราะห์ข้อมูล แม้แต่ธุรกิจขนาดใหญ่ก็ยังต้องดิ้นรนกับการจัดการข้อมูลและการจัดเก็บข้อมูลเพื่อให้มีปริมาณการใช้ข้อมูลจำนวนมหาศาล ปัญหานี้ไม่สามารถแก้ไขได้โดยเพียงแค่จัดเก็บข้อมูลที่เป็นเหตุผลที่องค์กรจำเป็นต้องระบุความท้าทายและดำเนินการแก้ไข:

- ความเข้าใจที่ไม่เหมาะสมและการยอมรับข้อมูลขนาดใหญ่

- ข้อมูลเชิงลึกที่มีความหมายผ่านการวิเคราะห์ข้อมูลขนาดใหญ่

- การจัดเก็บข้อมูลและคุณภาพ

- ความปลอดภัยและความเป็นส่วนตัวของข้อมูล

- การรวบรวมข้อมูลที่มีความหมายแบบเรียลไทม์: การขาดแคลนทักษะ

- การซิงโครไนซ์ข้อมูล

- การแสดงข้อมูลด้วยสายตา

- ความสับสนในการจัดการข้อมูล

- โครงสร้างข้อมูลขนาดใหญ่

- การดึงข้อมูลจาก data

ประโยชน์ของ Big Data ขององค์กร

บิ๊กดาต้าไม่มีประโยชน์ในการจัดระเบียบข้อมูล แต่มันยังนำประโยชน์มากมายมาสู่องค์กร ห้าอันดับแรกคือ:

- ทำความเข้าใจแนวโน้มของตลาด : การใช้ข้อมูลขนาดใหญ่และการวิเคราะห์ข้อมูลขนาดใหญ่ องค์กรสามารถคาดการณ์แนวโน้มของตลาด คาดการณ์ความต้องการของลูกค้า ประเมินประสิทธิภาพของผลิตภัณฑ์ ความชอบของลูกค้า และมองการณ์ไกลในพฤติกรรมของลูกค้าได้อย่างง่ายดาย ข้อมูลเชิงลึกเหล่านี้ตอบแทนช่วยให้เข้าใจรูปแบบการซื้อ รูปแบบการซื้อ การตั้งค่า และอื่นๆ ข้อมูลล่วงหน้าดังกล่าวช่วยในการวางแผนและจัดการสิ่งต่างๆ

- เข้าใจความต้องการของลูกค้า: การวิเคราะห์ Big Data ช่วยให้บริษัทต่างๆ เข้าใจและวางแผนความพึงพอใจของลูกค้าได้ดีขึ้น จึงส่งผลต่อการเติบโตของธุรกิจ การสนับสนุน 24*7 การแก้ไขข้อร้องเรียน การรวบรวมข้อเสนอแนะที่สอดคล้องกัน ฯลฯ

- การปรับปรุงชื่อเสียงของบริษัท : ข้อมูลขนาดใหญ่ช่วยจัดการกับข่าวลือเท็จ ให้บริการลูกค้าได้ดียิ่งขึ้นตามความต้องการ และรักษาภาพลักษณ์ของบริษัท เมื่อใช้เครื่องมือวิเคราะห์ข้อมูลขนาดใหญ่ คุณจะวิเคราะห์ทั้งอารมณ์ด้านลบและด้านบวกที่ช่วยให้เข้าใจความต้องการและความคาดหวังของลูกค้าได้

- ส่งเสริมมาตรการประหยัดต้นทุน : ต้นทุนเริ่มต้นในการปรับใช้ Big Data นั้นสูง แต่ให้ผลตอบแทนและข้อมูลเชิงลึกที่มากกว่าที่คุณจ่าย บิ๊กดาต้าสามารถใช้เก็บข้อมูลได้อย่างมีประสิทธิภาพมากขึ้น

- ทำให้ข้อมูลพร้อมใช้งาน : เครื่องมือสมัยใหม่ใน Big Data สามารถแสดงข้อมูลบางส่วนในเวลาจริงได้ตลอดเวลาในรูปแบบที่มีโครงสร้างและอ่านง่าย

ภาคส่วนที่ใช้ Big Data:

- ค้าปลีกและอีคอมเมิร์ซ

- บริการด้านการเงิน

- โทรคมนาคม

บทสรุป

ด้วยวิธีนี้ เราสามารถสรุปได้ว่าไม่มีคำจำกัดความเฉพาะเจาะจงว่าอะไรคือข้อมูลขนาดใหญ่ แต่ถึงกระนั้นเราทุกคนก็เห็นด้วยว่าข้อมูลจำนวนมากเป็นข้อมูลขนาดใหญ่ นอกจากนี้ เมื่อเวลาผ่านไป ความสำคัญของการวิเคราะห์ข้อมูลขนาดใหญ่ก็เพิ่มขึ้น เนื่องจากช่วยปรับปรุงความรู้และได้ข้อสรุปที่สร้างผลกำไร

หากคุณอยากได้รับประโยชน์จากข้อมูลขนาดใหญ่ การใช้ Hadoop จะช่วยคุณได้อย่างแน่นอน เนื่องจากเป็นวิธีการที่รู้วิธีจัดการข้อมูลขนาดใหญ่และทำให้เข้าใจได้